Зачем мне этот шаблон?

Большинство софта не умеет чистить дубли проксей. Это приводит к тому, что вы теряете время, когда проверяете(чекаете) одни и те же прокси, которые были одновременно сразу в нескольких источниках(паблик прокси листах).

Бывает так, что софт умеет чистить дубли проксей, однако, эта процедура может нехило отъедать ресурсы вашего компа/сервера в зависимости от того насколько большая у вас база.

Я встречал ещё софт который весь процесс парсинга производит через браузер Internet Explorer, вообще не понимаю создателей таких парсеров - зачем? Когда есть гет запросы)))

Чтобы оптимизировать часть процесса поиска проксей был написан данный шаблон, который во многопотоке GET запросами проходит всю базу с прокси листами и выпаршивает регуляркой всю найденную проксю в фаил proxys.txt

Остаётся только убрать дубли прокси из полученного фаила и можно заряжать всё в свой проксичекер. По моему опыту: когда я в последний раз после парсинга удалил дубли - у меня вышло около 3 кк уникальной прокси. Представьте сколько времени бы занял чек такой базы имея дубли, не говоря уже о том что база в 3 кк чекается довольно долго.

Как работает шаблон

Скачиваем, распаковываем в нужную папку фаилы шаблона. Закидываем в фаил url-list.txt все проксилисты которые у вас есть.

Смотрим сколько у нас строк и пишем в самом зенно постере столько же строк в графу "сколько делать". Запускаем в столько потоков сколько нам нужно.

В процессе парсинга внутри папки шаблона появится фаил proxys.txt с результатом.

Как завершите парсинг удалите дубли. Я это делаю KeyWordKeeper'ом он тоже лежит в архиве.

Также я добавил фаил Filters-bad-urls.txt в нём содержатся мусорные адреса прокси листов, которые часто попадают в базу но не содержат прокси. Можно тем же KeyWordKeeper'ом сделать выборку из базы листов, поместив в исключения урлы из бэд урлс.

Каких результатов можно достичь

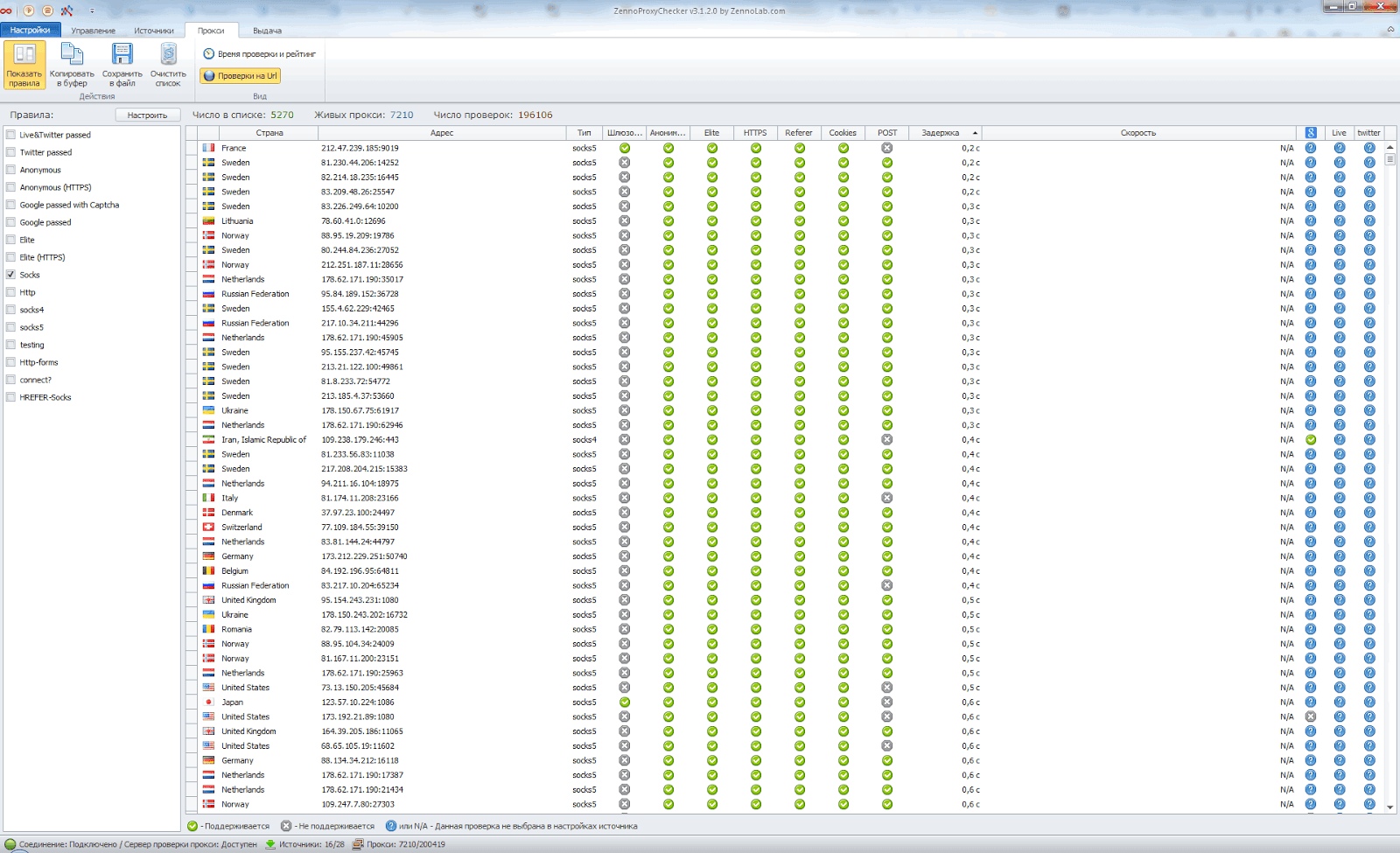

Если делать все правильно, то можно спокойно набрать 5-10 к живых соксов. Обратите внимание именно соксов, а не http прокси, в этом можно убедиться посмотрев скрин ниже. Все прокси уникальные, не повторяются, на многих открыты интересные порты.

Не забывайте сохранять результаты чека. Они вам пригодятся, когда понадобится быстро получить много живых прокси. У меня в виду особенности работы софта, вся живая прокся сохраняется в 3 отдельных фаила:

- all-alive-http-proxy.txt

- all-alive-socks4.txt

- all-alive-socks5.txt

Время от времени я чищу фаилы от дублей. И когда нужно очень быстро получаю много живых проксей, чекая только эти фаилы.

отличная статья...

ОтветитьУдалитьРезультат действительно отличный.

ОтветитьУдалитьОтправить комментарий