Необходимые требования

Берем для опытов какую нибудь базу побольше. Я взял сыруху на 1 кк ссылок которую парсил 2-3 дня назад. Ещё нам понадобится сама TextPipe Pro и сайт regexr.com на котором очень удобно составлять регулярки.

Вся суть сводится к тому чтобы сначала найти ненужные ссылки, которые хрумом не пробьются.

Скорее всего это будут популярные web 2.0 сервисы, к которым нужен отдельный подход или мод. Или по каким то причинам данные ресы тормозят прогон потому что перенасыщены рекапчей, кейкапчей, лагают, притворяются нерабочими и т.д

Так вот сначала мы по простейшим признакам выпаршиваем из базы такие ресы в отдельную базу. Затем делаем под них универсальную регулярку, проверяем её, если все ок то используем. Сразу скажу - процесс довольно трудоемкий, однако, сэкономит очень много времени в дальнейшем.

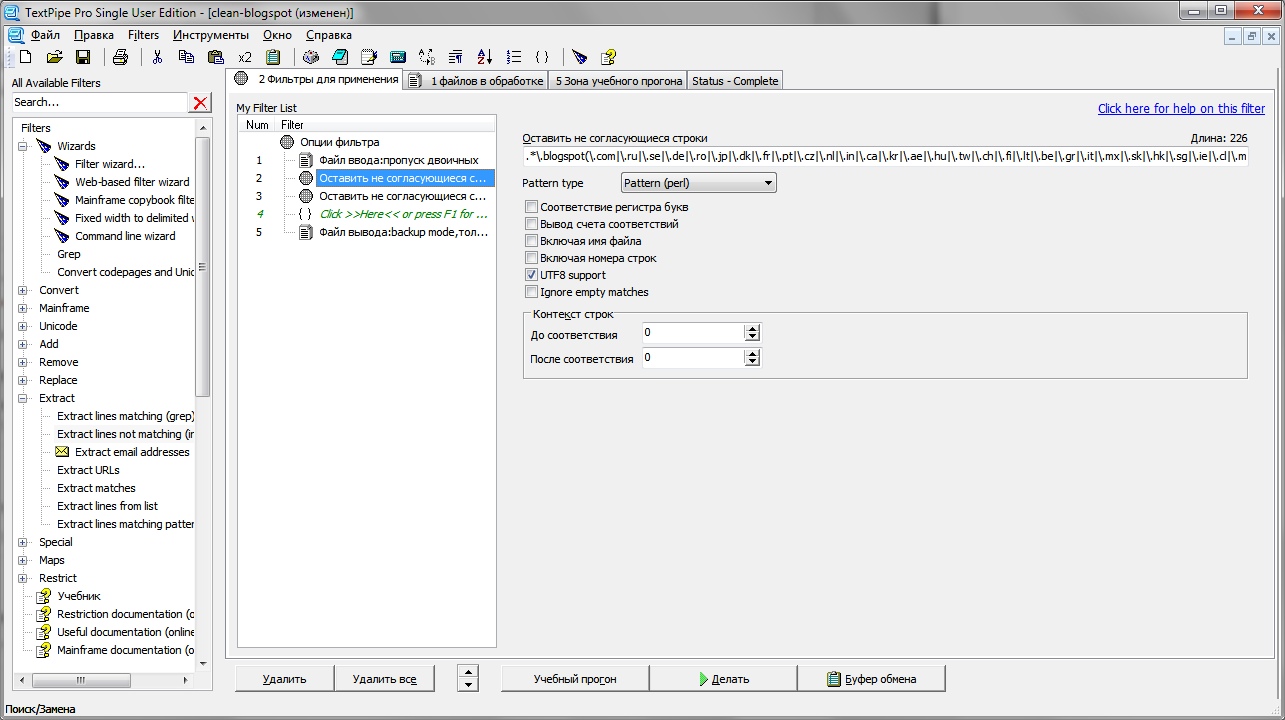

Открываем Text Pipe pro и добавляем нашу базу для обработки.

Выбираем в фильтрах Extract > Extract lines not matching (inverse grep) то есть извлечь все строки не подходящие к следующим рег. экспам:

И первым у нас будет blogspot, который мы удалим при помощи такого рег. экспа:

Следом у нас будут web2.0 сервисы и блоги - вордпрессы, лайвджорналы, tumblr, weebly и т.д.:

Хостинги картинок(не могу представить каким образом они попадают в базу, но они нам не нужны)

Бесплатные хостинги. Бурж хосты, добавлю чуть позже:

Отдельного внимания заслуживает ucoz(список пока неполный):

Ещё ucoz:

Ссылки на отправку почты:

Весь список еще неполный и будет периодически обновляться.

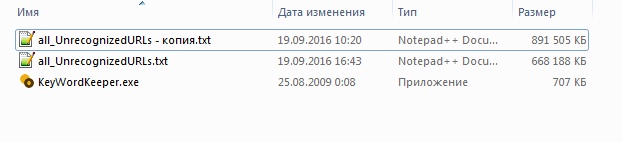

Наглядный пример использования данного метода, показывает сколько можно экономить времени отсекая ненужные сайты и сервисы. 223 mb ресурсов мы отсекли буквально за 5 минут, а сколько времени у нас бы занял чек этих ресурсов.

Могу сказать что как то чекал подряд много юкоза, без прокси. И он резал скорость чека на столько что где то 300к-600к ссылок чекалось часов 11.

Отличный материал, спасибо. У меня хрум валяется уже 9 лет, думаю пришло время сдуть с него пыль и начать изучать)

ОтветитьУдалитьНу ксевил, конечно, трудится.

Отправить комментарий